Aggiornamenti recenti Aprile 2nd, 2025 10:39 AM

News Recenti

- Transparency Center Initiative di Kaspersky Lab: cosa significa per l’Italia

- Corea del Nord: la minaccia cyber si espande in Europa grazie ai professionisti IT

- Le vulnerabilità dei tool RMM aprono nuove opportunità ai cybercriminali

- Una campagna di phishing usa il DNS-over-HTTPS per eludere i controlli

- CERT-AGID 22-28 marzo: in vendita sul darkweb i documenti dello smishing a tema INPS

- SharePoint inondato dallo spam: la colpa è di un dominio Stream compromesso

Con l’intelligenza artificiale i malware riescono ad aggirare gli antivirus

Lug 31, 2017 Marco Schiaffino In evidenza, Malware, News, RSS, Tecnologia 2

Il progetto sfrutta un sistema per inserire modifiche nel codice dei malware ed evitarne il rilevamento. E rischia di funzionare…

Si fa un gran parlare dell’uso dell’intelligenza artificiale (AI) nell’individuazione dei malware. Mentre le società di sicurezza la stanno implementando nei loro sistemi per migliorare le capacità di rilevamento delle minacce sconosciute, qualcuno ha già cominciato a lanciare l’allarme sulla possibilità che questa tecnologia possa essere usata anche dai cyber-criminali con obiettivi esattamente opposti.

Una delle prime “prove sul campo” è stata presentata al DEF CON 2017 di Las Vegas da Hyrum Anderson di Endgame. L’esperimento sfrutta la piattaforma OpenAI creata da Elon Musk e si pone l’obiettivo di utilizzare l’intelligenza artificiale per creare malware che gli antivirus non sono in grado di rilevare.

La logica, insomma, è quella di combattere il fuoco con il fuoco. Intelligenza artificiale contro intelligenza artificiale.

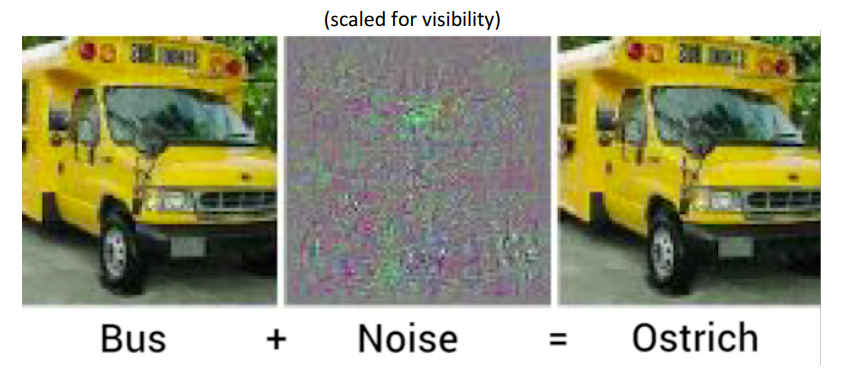

L’assunto da cui è partita la ricerca è che il machine learning ha dei difetti e, in particolare, può essere ingannato attraverso piccole modifiche. Nella sua presentazione (disponibile qui) Anderson cita l’esempio dei sistemi di riconoscimento delle immagini e della possibilità di ingannarli facendo in modo che la foto di un furgone venga scambiata per uno struzzo.

Per un occhio umano rimane sempre un furgone. L’intelligenza artificiale, però, viene ingannata dal disturbo inserito nell’immagine.

La strategia usata è quella di alterare la struttura del codice dei malware, facendo in modo che abbiano caratteristiche tali da non “insospettire” i sistemi antivirus basati sul Machine Learning.

A questo scopo il team di ricercatori ha avviato una simulazione mettendo a confronto un “agente” in grado di elaborare malware con queste caratteristiche e un motore antivirus. L’obiettivo era quello di arrivare a un sistema che fosse in grado di “imparare” come aggirare il sistema di analisi del software di sicurezza.

I risultati dell’esperimento non sono tanto importanti in valore assoluto, quanto nella prospettiva del miglioramento. Stando ai risultati pubblicati nella ricerca, dopo 15 ore in cui la piattaforma ha macinato circa 100.000 tentativi, il numero di sample individuati dall’antivirus sono passati da 35 su 62 a 25 su 62.

Insomma, l’utilizzo dell’intelligenza artificiale per aggirare il machine learning sarebbe efficace. Anderson ha reso disponibile il software necessario per replicare esperimenti simili su GitHub. C’è da scommettere che molte società di sicurezza ci si butteranno sopra.

Articoli correlati

-

Microsoft annuncia nuovi agenti per...

Microsoft annuncia nuovi agenti per...Mar 25, 2025 0

-

Attenzione ai convertitori di file...

Attenzione ai convertitori di file...Mar 24, 2025 0

-

CERT-AGID 1-7 marzo: bot fasulli,...

CERT-AGID 1-7 marzo: bot fasulli,...Mar 11, 2025 0

-

CERT-AGID 22-28 febbraio: nuove...

CERT-AGID 22-28 febbraio: nuove...Mar 03, 2025 0

Altro in questa categoria

-

Corea del Nord: la minaccia cyber si...

Corea del Nord: la minaccia cyber si...Apr 02, 2025 0

-

Le vulnerabilità dei tool RMM aprono...

Le vulnerabilità dei tool RMM aprono...Apr 01, 2025 0

-

Una campagna di phishing usa il...

Una campagna di phishing usa il...Mar 31, 2025 0

-

CERT-AGID 22-28 marzo: in vendita sul...

CERT-AGID 22-28 marzo: in vendita sul...Mar 31, 2025 0

Last Week Security IT

Spyware nordcoreano e bot malvagi

Approfondimenti

-

Corea del Nord: la minaccia cyber si espande in Europa...

Corea del Nord: la minaccia cyber si espande in Europa...Apr 02, 2025 0

La Corea del Nord sta incrementando le proprie attività... -

Le vulnerabilità dei tool RMM aprono nuove opportunità ai...

Le vulnerabilità dei tool RMM aprono nuove opportunità ai...Apr 01, 2025 0

Se da una parte i tool di Remote Monitoring and Management... -

Mimecast: con l’AI una nuova era per la Data Loss...

Mimecast: con l’AI una nuova era per la Data Loss...Mar 27, 2025 0

Ogni nuova tecnologia porta con sé nuovi rischi. Nel caso... -

Penetration testing, una volta ogni tanto non basta più:...

Penetration testing, una volta ogni tanto non basta più:...Mar 21, 2025 0

Il processo di penetration testing è ormai una pratica... -

Il ransomware Medusa ha colpito oltre 300 infrastrutture...

Il ransomware Medusa ha colpito oltre 300 infrastrutture...Mar 13, 2025 0

Il bilancio delle vittime del ransomware Medusa è...

Minacce recenti

Le vulnerabilità dei tool RMM aprono nuove opportunità ai cybercriminali

CERT-AGID 22-28 marzo: in vendita sul darkweb i documenti dello smishing a tema INPS

RedCurl passa al ransomware: scoperto il primo attacco con QWCrypt

Off topic

-

L’IA generativa unifica le interfacce di gestione e...

L’IA generativa unifica le interfacce di gestione e...Gen 29, 2025 0

Con l’avvento dell’IA generativa... -

Cyberinsurance: misurare il rischio umano può...

Cyberinsurance: misurare il rischio umano può...Ott 09, 2024 0

Negli ultimi anni sempre più aziende stanno sottoscrivendo... -

Il machine learning di Kaspersky aumenta la capacità di...

Il machine learning di Kaspersky aumenta la capacità di...Ott 02, 2024 0

Grazie al machine learning, il Global Research and Analysis... -

I vertici aziendali non sono del tutto pronti alle nuove...

I vertici aziendali non sono del tutto pronti alle nuove...Set 30, 2024 0

Il 2024 è l’anno delle nuove normative di sicurezza:... -

Più della meta delle aziende geo-distribuite ha problemi...

Più della meta delle aziende geo-distribuite ha problemi...Mag 21, 2024 0

Una delle sfide principali delle aziende distribuite sul...

Post recenti

-

Corea del Nord: la minaccia cyber si espande in Europa...

Corea del Nord: la minaccia cyber si espande in Europa...Apr 02, 2025 0

La Corea del Nord sta incrementando le proprie attività... -

Le vulnerabilità dei tool RMM aprono nuove opportunità ai...

Le vulnerabilità dei tool RMM aprono nuove opportunità ai...Apr 01, 2025 0

Se da una parte i tool di Remote Monitoring and... -

Una campagna di phishing usa il DNS-over-HTTPS per eludere...

Una campagna di phishing usa il DNS-over-HTTPS per eludere...Mar 31, 2025 0

I ricercatori di Infoblox hanno scoperto una nuova campagna... -

CERT-AGID 22-28 marzo: in vendita sul darkweb i documenti...

CERT-AGID 22-28 marzo: in vendita sul darkweb i documenti...Mar 31, 2025 0

Nel corso dell’ultima settimana, il CERT-AGID ha rilevato... -

SharePoint inondato dallo spam: la colpa è di un dominio...

SharePoint inondato dallo spam: la colpa è di un dominio...Mar 28, 2025 0

Un vecchio dominio di Microsoft Stream è stato compromesso...

2 thoughts on “Con l’intelligenza artificiale i malware riescono ad aggirare gli antivirus”