Aggiornamenti recenti Aprile 4th, 2025 12:39 PM

News Recenti

- Transparency Center Initiative di Kaspersky Lab: cosa significa per l’Italia

- L’Italia è tra gli obiettivi principali del cybercrime

- Colt ha completato il trial di crittografia quantistica sulla propria rete ottica

- Corea del Nord: la minaccia cyber si espande in Europa grazie ai professionisti IT

- Le vulnerabilità dei tool RMM aprono nuove opportunità ai cybercriminali

- Una campagna di phishing usa il DNS-over-HTTPS per eludere i controlli

Difendersi dai bot è una missione possibile?

Apr 03, 2017 Marco Schiaffino Approfondimenti, In evidenza, Mercato, RSS, Tecnologia 0

L’attività dei sistemi automatici dannosi rischia di mettere in crisi le infrastrutture aziendali. Akamai: “ecco come è possibile controllarli”.

Quando leggiamo i dati relativi alle visite a un sito Web, siamo naturalmente portati a pensare che dietro a tutto il traffico Internet generato ogni giorno ci siano persone in carne e ossa.

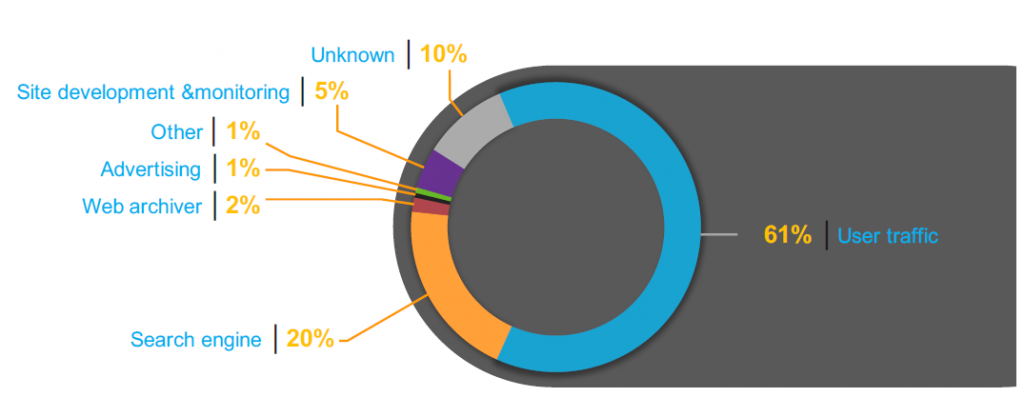

Nulla di più sbagliato: secondo le più recenti statistiche una bella fetta dell’attività sul Web è in realtà attribuibile ai cosiddetti “bot”, programmi automatici che si collegano ai siti Internet per i più svariati motivi e che in media rappresentano il 39% del traffico complessivo.

Ma cosa fanno questi bot e perché rappresentano un problema per le aziende che operano su Internet? “Quando si parla di bot, ci si trova di fronte a un panorama complesso” spiega Stefano Ruggiero, Security Technical Project Manager di Akamai.

“Molti di questi agent sono perfettamente legittimi e addirittura indispensabili per l’attività delle aziende. Basti pensare a quelli usati dai motori di ricerca come Google o Bing per indicizzare le pagine Web. Altri, invece, sono decisamente dannosi”.

Il caso più eclatante riguarda quello denunciato dagli esperti di sicurezza nei giorni scorsi e che ha preso di mira i siti che usano le gift card. Esistono però tipologie di bot che si limitano ad accedere a informazioni disponibili, utilizzandole però in maniera dannosa per le aziende.

Nella categoria rientrano, per esempio, anche i cosiddetti “price scraper”, cioè i bot che analizzano le pagine dei siti di e-commerce per registrare i prezzi dei prodotti in vendita e trasmetterli agli aggregatori.

Ma non solo: anche bot che non provocano un danno diretto, rischiano di causare problemi alle infrastrutture Web, aumentando a dismisura il traffico e mettendo a rischio le prestazioni dei siti Internet interessati.

“Il vero problema in questo ambito è che i bot sono spesso difficili da individuare, perché fanno di tutto per nascondere la loro reale natura” spiega Ruggiero, “per esempio simulando un comportamento simile a quello di un normale utente”.

Come individuare quindi i bot dannosi? “Il sistema adottato da Akamai (Bot Manager – ndr) utilizza diverse strategie, per esempio creando un fingerprint di ogni connessione e analizzandone il comportamento per capire se si tratti di un bot”.

Solo il 61% del traffico Internet sui siti Web deriva da attività “umane”. Il resto origina da bot di varia natura.

In alcuni casi, però, i bot dannosi usano una tecnica diversa: non nascondono la loro natura di software automatici, ma cercano di spacciarsi per qualcos’altro, utilizzando per esempio lo user agent di un bot legittimo come quelli usati dai motori di ricerca.

“In questo caso l’identificazione avviene attraverso parametri diversi” spiega Ruggiero. “In un caso simile, per esempio quando un bot malevolo si spaccia per l’agent di Google, verifichiamo una serie di informazioni come l’indirizzo IP da cui si collega”.

“Nel caso di un bot legittimo, anche l’IP da cui si collega farà riferimento a Google. Se risulta registrato a qualcun altro, sappiamo che quel bot non è quello che dice di essere e, di conseguenza, deve essere mitigato”.

Qui, però, nasce un altro problema: bloccare completamente l’attività dei bot rischia di rivelarsi controproducente. Chi li controlla, infatti, giungerà alla conclusione di essere stato individuato e, proprio come succede con i malware, ne modificherà caratteristiche e comportamento per aggirare i controlli.

Motivo per cui Akamai ha sviluppato una serie di strategie alternative. “Il modo migliore per evitare che i bot vengano adattati alle nuove condizioni è impedirgli di capire che sono stati individuati” spiega Ruggiero. “Al posto di bloccarli, adottiamo una serie di accorgimenti che ci permettono di ridurne l’impatto dal punto di vista del traffico e di impedirgli di svolgere la funzione per cui sono programmati”.

Per quanto riguarda la gestione del traffico, una soluzione possibile è quella di dirottare i bot su altri siti ospitati su cloud, in modo da scongiurare il rischio che possano congestionare i server principali.

Per “disinnescare” i possibili danni legati all’attività dei siti, invece, vengono usate tecniche più raffinate. “Bot Manager consente di applicare diverse tecniche di mitigazione, che comprendono per esempio il cosiddetto tarpit” conferma Ruggiero.

Si tratta, in pratica, di prendere i bot per sfinimento. Il server, una volta riconosciuto il bot, mantiene aperta una connessione ma non invia alcun dato. In questo modo l’autore del bot non penserà di essere stato bloccato, ma che ci sia un problema di connessione che impedisce la comunicazione con il sito.

Per quanto riguarda bot dedicati al price scraping, invece, una delle soluzioni più efficaci è quella di… mentirgli. “Il nostro sistema permette di dirottare questo tipo di bot su pagine Web identiche a quelle del sito originale, ma che contengono informazioni false”. Ci spiega il Security Technical Project Manager di Akamai. “In questo modo possiamo bloccare l’attività dei cyber-criminali facendo in modo che non se ne accorgano nemmeno.”

Articoli correlati

-

Aumentano gli attacchi alle...

Aumentano gli attacchi alle...Set 02, 2024 0

-

Gli attacchi DDoS sono in aumento...

Gli attacchi DDoS sono in aumento...Lug 01, 2024 0

-

L’area EMEA è la più colpita...

L’area EMEA è la più colpita...Giu 05, 2024 0

-

I siti di phishing legati a USPS...

I siti di phishing legati a USPS...Apr 29, 2024 0

Altro in questa categoria

-

L’Italia è tra gli obiettivi...

L’Italia è tra gli obiettivi...Apr 04, 2025 0

-

Colt ha completato il trial di...

Colt ha completato il trial di...Apr 03, 2025 0

-

Corea del Nord: la minaccia cyber si...

Corea del Nord: la minaccia cyber si...Apr 02, 2025 0

-

Le vulnerabilità dei tool RMM aprono...

Le vulnerabilità dei tool RMM aprono...Apr 01, 2025 0

Last Week Security IT

Spyware nordcoreano e bot malvagi

Approfondimenti

-

L’Italia è tra gli obiettivi principali del...

L’Italia è tra gli obiettivi principali del...Apr 04, 2025 0

L’Italia è tra i principali obiettivi del cybercrime... -

Corea del Nord: la minaccia cyber si espande in Europa...

Corea del Nord: la minaccia cyber si espande in Europa...Apr 02, 2025 0

La Corea del Nord sta incrementando le proprie attività... -

Le vulnerabilità dei tool RMM aprono nuove opportunità ai...

Le vulnerabilità dei tool RMM aprono nuove opportunità ai...Apr 01, 2025 0

Se da una parte i tool di Remote Monitoring and Management... -

Mimecast: con l’AI una nuova era per la Data Loss...

Mimecast: con l’AI una nuova era per la Data Loss...Mar 27, 2025 0

Ogni nuova tecnologia porta con sé nuovi rischi. Nel caso... -

Penetration testing, una volta ogni tanto non basta più:...

Penetration testing, una volta ogni tanto non basta più:...Mar 21, 2025 0

Il processo di penetration testing è ormai una pratica...

Minacce recenti

Corea del Nord: la minaccia cyber si espande in Europa grazie ai professionisti IT

Le vulnerabilità dei tool RMM aprono nuove opportunità ai cybercriminali

CERT-AGID 22-28 marzo: in vendita sul darkweb i documenti dello smishing a tema INPS

Off topic

-

L’IA generativa unifica le interfacce di gestione e...

L’IA generativa unifica le interfacce di gestione e...Gen 29, 2025 0

Con l’avvento dell’IA generativa... -

Cyberinsurance: misurare il rischio umano può...

Cyberinsurance: misurare il rischio umano può...Ott 09, 2024 0

Negli ultimi anni sempre più aziende stanno sottoscrivendo... -

Il machine learning di Kaspersky aumenta la capacità di...

Il machine learning di Kaspersky aumenta la capacità di...Ott 02, 2024 0

Grazie al machine learning, il Global Research and Analysis... -

I vertici aziendali non sono del tutto pronti alle nuove...

I vertici aziendali non sono del tutto pronti alle nuove...Set 30, 2024 0

Il 2024 è l’anno delle nuove normative di sicurezza:... -

Più della meta delle aziende geo-distribuite ha problemi...

Più della meta delle aziende geo-distribuite ha problemi...Mag 21, 2024 0

Una delle sfide principali delle aziende distribuite sul...

Post recenti

-

L’Italia è tra gli obiettivi principali del...

L’Italia è tra gli obiettivi principali del...Apr 04, 2025 0

L’Italia è tra i principali obiettivi del cybercrime... -

Colt ha completato il trial di crittografia quantistica...

Colt ha completato il trial di crittografia quantistica...Apr 03, 2025 0

Colt Technology Services ha annunciato di aver completato... -

Corea del Nord: la minaccia cyber si espande in Europa...

Corea del Nord: la minaccia cyber si espande in Europa...Apr 02, 2025 0

La Corea del Nord sta incrementando le proprie attività... -

Le vulnerabilità dei tool RMM aprono nuove opportunità ai...

Le vulnerabilità dei tool RMM aprono nuove opportunità ai...Apr 01, 2025 0

Se da una parte i tool di Remote Monitoring and... -

Una campagna di phishing usa il DNS-over-HTTPS per eludere...

Una campagna di phishing usa il DNS-over-HTTPS per eludere...Mar 31, 2025 0

I ricercatori di Infoblox hanno scoperto una nuova campagna...